برای این که سایت شما بیشتر دیده شود و افراد زیادی وارد آن شوند راههای مختلفی وجود دارد. یکی از این راهها سئو است. سئو در اصل باعث میشود که سایت شما در صفحات اول موتورهای جستجو مثل گوگل نمایش داده شود. بنابراین وقتی افراد مختلف عبارتی را سرچ میکنند، احتمال این که وارد سایت شما شوند بیشتر میشود. گوگل رباتهای بسیار زیادی در سطح وب دارد که کارشان بررسی سایتهای مختلف است. این رباتها بیوقفه و شبانه روزی سایتهای مختلف را چک میکنند و براساس کیفیت آنها رتبه خاصی به صفحات سایت میدهند.

رباتهای گوگل به صورت پیشفرض تمام صفحات سایتها که به آن دسترسی داشته باشند را بررسی خواهند کرد. بعضی از صفحات سایت لازم است که حتما در گوگل قرار بگیرند و نمایش داده شوند. مثلا صفحه محصولات و مقالات از این دست صفحات هستند که حتما باید در موتور جستجوی گوگل حضور داشته باشند. در نتیجه رباتهای گوگل حتما باید به این صفحات دسترسی داشته باشند. بعضی از صفحات سایت هم هستند که لزومی ندارد در گوگل ایندکس شده و نمایش داده شوند. مثلا صفحه عضویت یا ورود به سایت و صفحات بخش ادمین سایت جزو این دسته هستند.

یکی از مواردی که در سئو باید رعایت کنید این است که رباتهای گوگل صفحات غیرضروری شما را در نتایج جستجو وارد نکنند. حالا چرا باید این کار انجام شود؟ دلیلش این است که این صفحات از نظر گوگل سئوی مناسبی ندارند. به عنوان نمونه صفحه محصول شما محتوای خوبی دارد و روی سئو آن کار کردهاید. پس باید رباتهای گوگل به آن دسترسی داشته باشند. از طرف دیگر صفحه ادمین شما ارزش زیادی برای بازدیدکنندگان ندارد و هیچ سایتی هم به سئو صفحه ادمین اهمیتی نمیدهد. به همین دلیل باید به رباتهای گوگل بگوییم که این صفحه را اصلا در نتایج جستجو وارد نکنند.

شما میتوانید به رباتهای گوگل بگویید که کدام صفحات سایتتان را بررسی کنند و کدامیک را بررسی نکنند و در نتایج گوگل نمایش ندهند. این کار از طریق یک فایل متنی به اسم robots.txt انجام میشود. شما در این فایل میتوانید یکسری فرمانها برای رباتهای گوگل آماده کنید. رباتهای گوگل هم حتما به این فرمانها توجه میکنند. هر بار که رباتهای گوگل و سایر موتورهای جستجو وارد سایت شما میشوند، اول از همه فایل robots.txt را بررسی میکنند. این فایل به رباتها میگوید که به کدام قسمت از سایت مجوز دسترسی دارند. رباتها هم دقیقا برمبنای همین فایل، سایت شما را بررسی میکنند.

تنظیم دقیق و درست فایل robots.txt یکی از کارهای اولیه در سئو سایت است و اهمیت زیادی دارد. در این فایل باید مشخص کنید که رباتهای گوگل و بقیه موتورهای جستجو به کدام بخش از سایت دسترسی داشته باشند و به کدام قسمتها دسترسی ندارند. در ویدیو زیر به صورت کامل آموزش دادیم که چطور فایل robots.txt را تنظیم کرده و بعضی از صفحات سایت را از دسترس رباتها خارج کنید.

مرحله اول: مشاهده فایل robots.txt

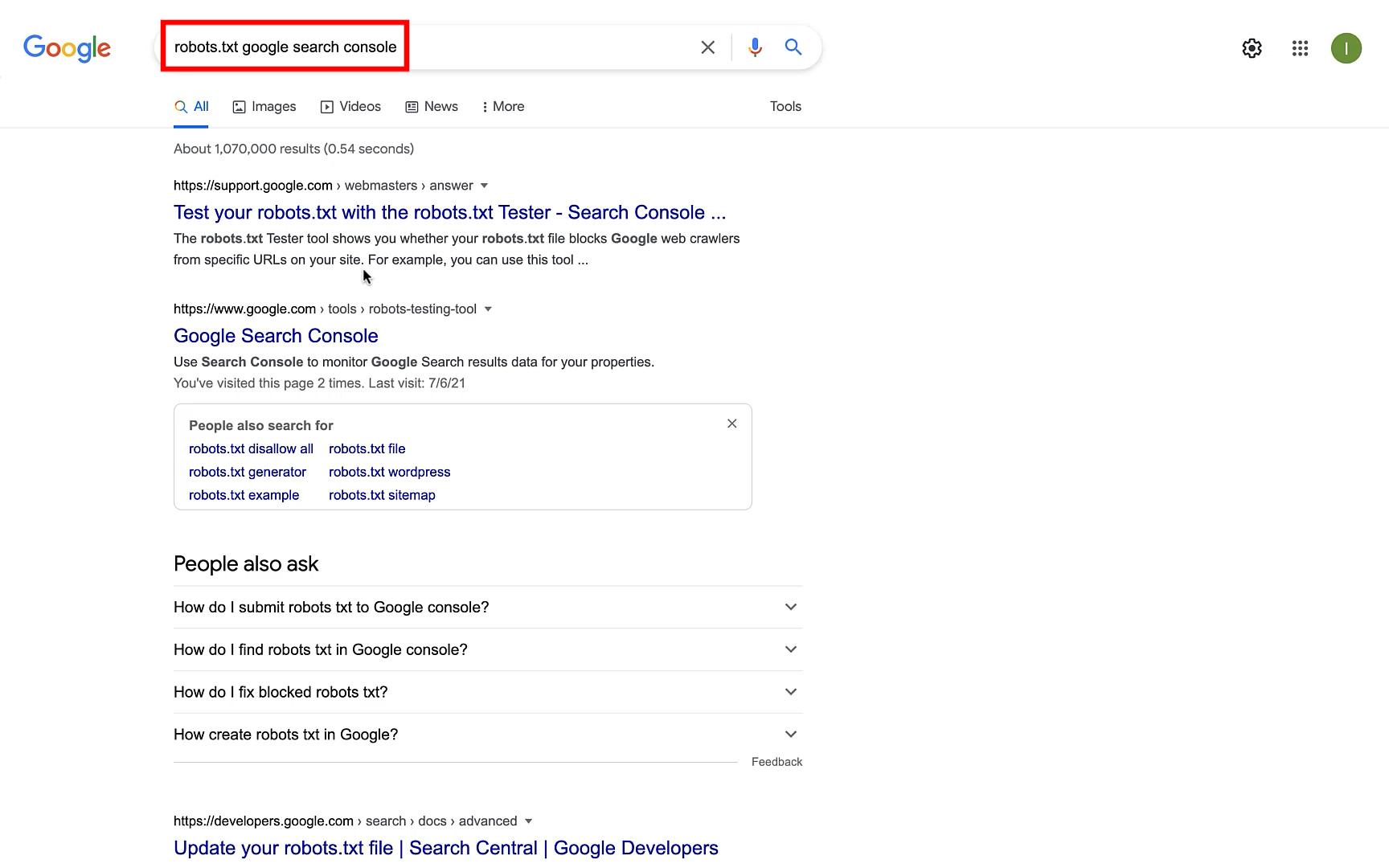

قدم اول این است که ابتدا فایل robots.txt سایتتان را ببینید. در این فایل نوشته شده است که رباتهای گوگل به کدام قسمتهای سایت میتوانند دسترسی داشته باشند. برای دسترسی به فایل robots.txt اول از همه عبارت robots.txt google search console را در گوگل جستجو کنید.

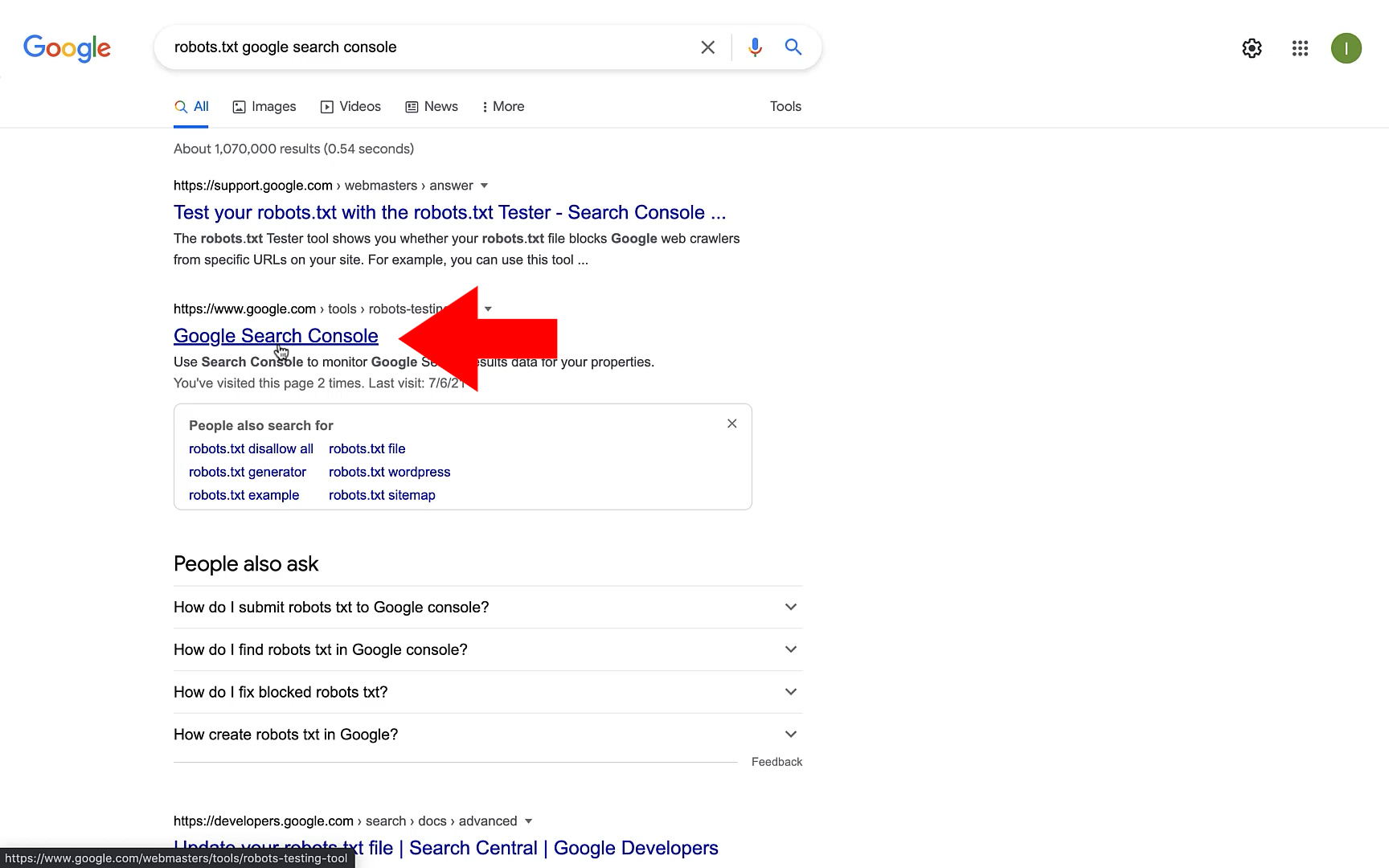

معمولا دومین گزینه در لیست نتایج گوگل مربوط به گوگل سرچ کنسول است که باید روی آن کلیک کنید.

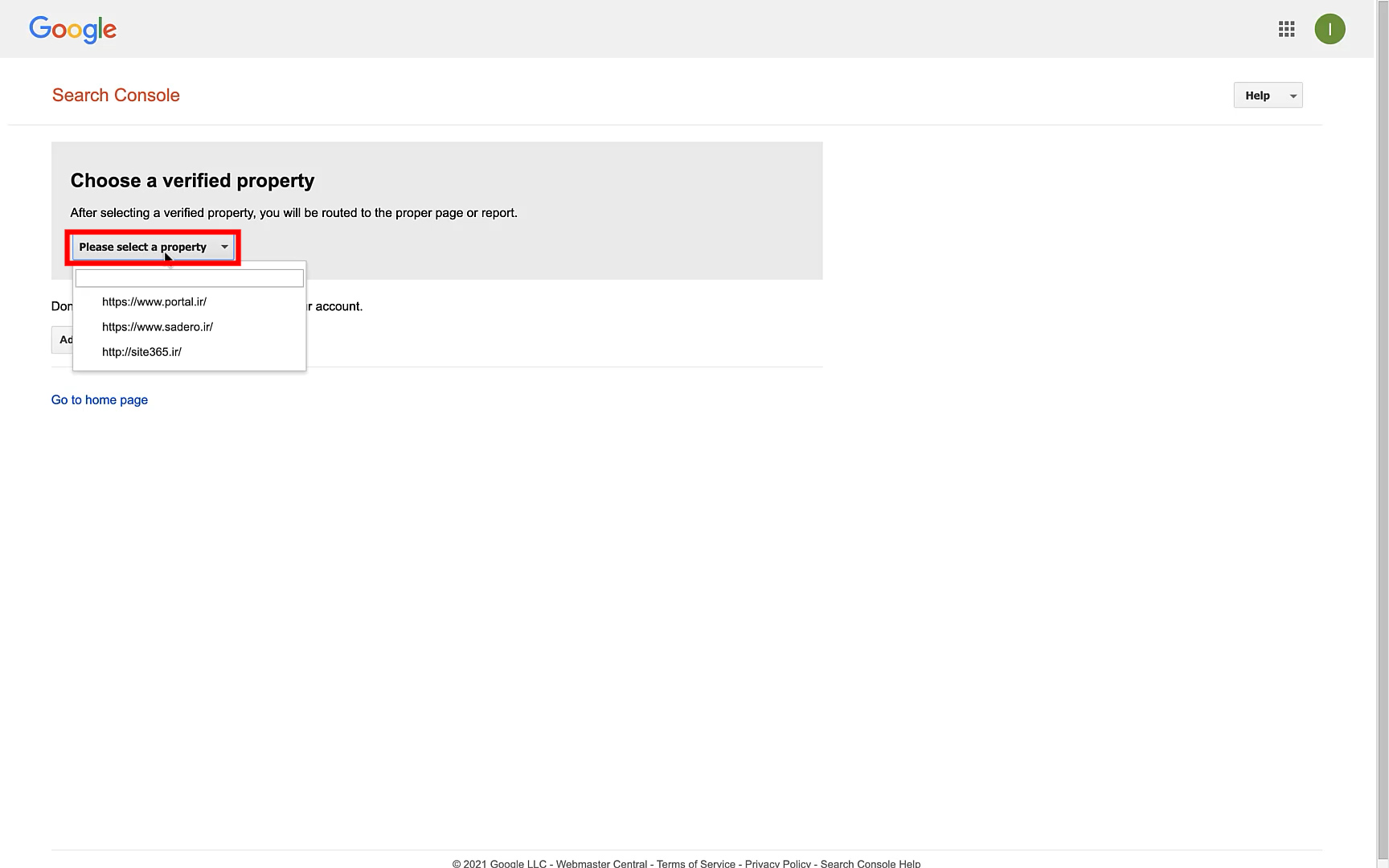

وقتی که روی لینک سرچ کنسول کلیک کردید، با صفحه زیر مواجه میشوید. روی گزینه Please select a property کلیک کنید. در ادامه لیستی از سایتهای شما نمایش داده میشود. روی سایت موردنظر کلیک کرده تا فایل robots.txt آن را ببینید.

مرحله دوم: تغییر فایل robots.txt

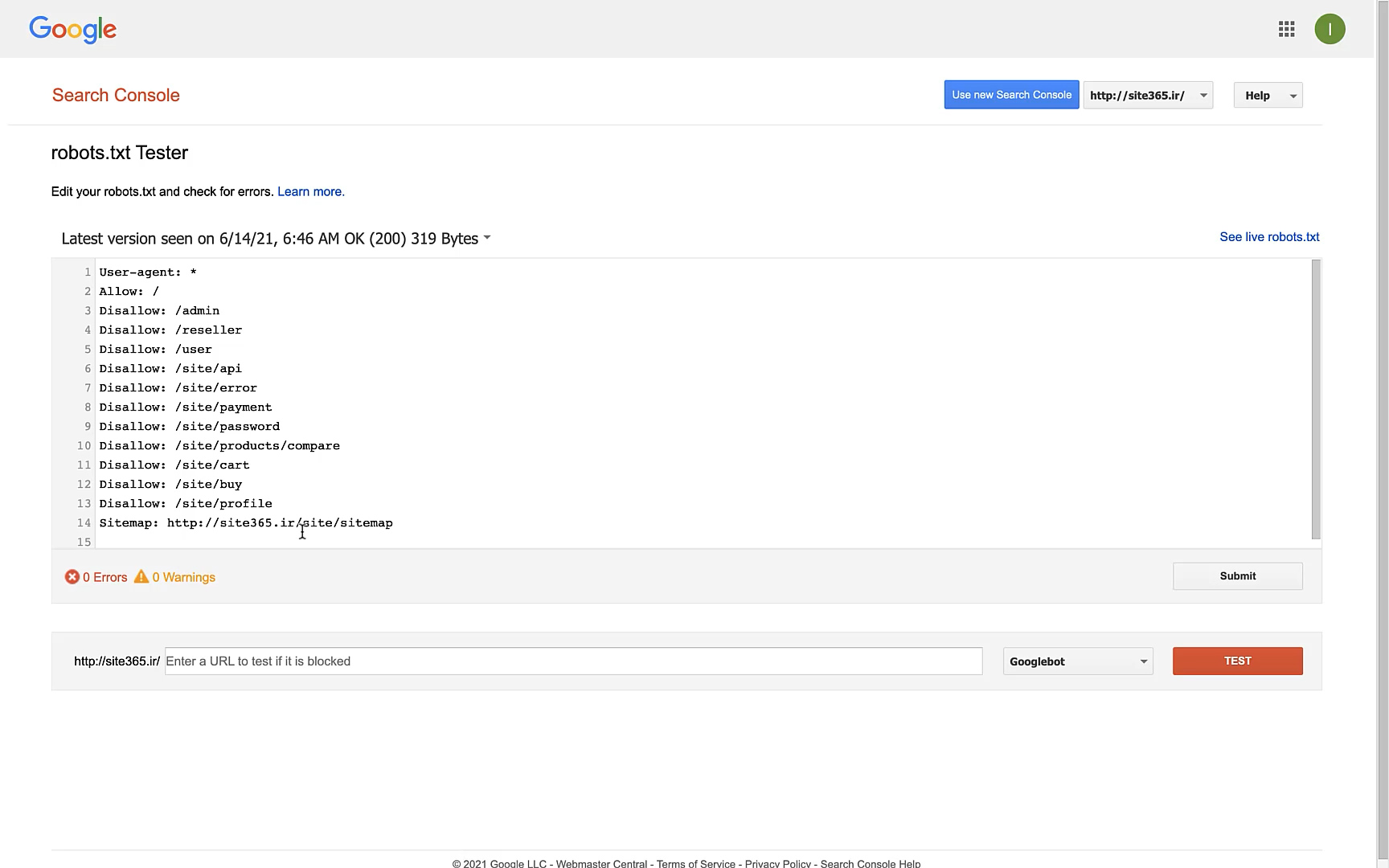

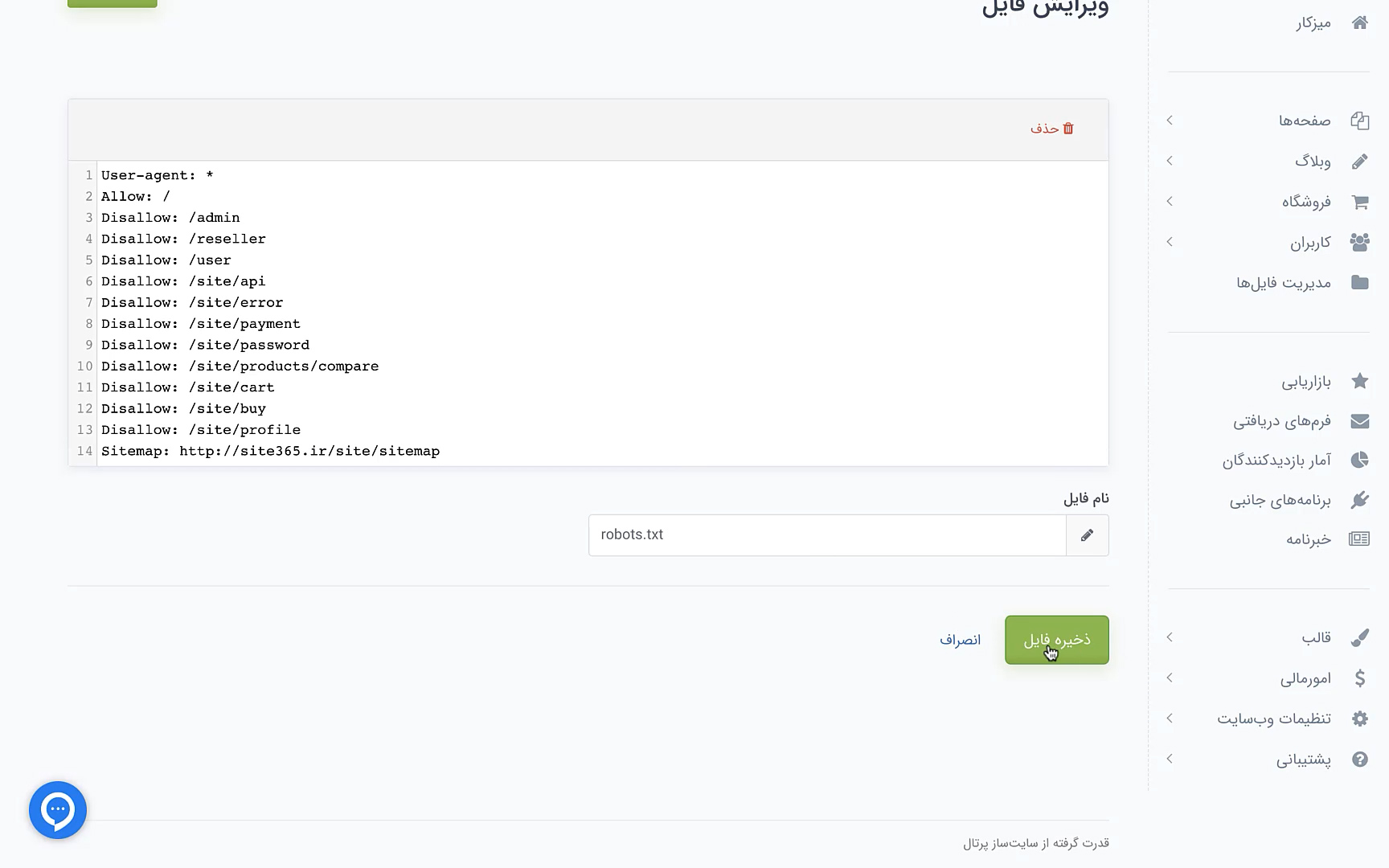

در ادامه صفحهای مثل عکس زیر برای شما باز میشود. این صفحه محتوای فایل robots.txt سایت شما را نمایش میدهد. داخل کادر وسط صفحه یکسری عبارت نوشته شدهاند که در مورد آنها به شما توضیح میدهیم. در خط دوم محتوای فایل robots.txt عبارت / :Allows نوشته شده است. این عبارت یعنی رباتهای سطح اینترنت میتوانند به همه صفحات سایت شما دسترسی داشته باشند. حالا در خطهای بعدی عباراتی نوشته شده است که ابتدای آنها Disallow قرار دارد. جلوی Disallow آدرس صفحاتی را مینویسیم که رباتهای اینترنتی قرار نیست به آنها دسترسی داشته باشند.

مثلا در خط سوم فایل، عبارت Disallow: /admin نوشته شده است. یعنی این که رباتها به تمام صفحات سایت شما به جز صفحه ادمین آن دسترسی دارند. همچنین موارد دیگری که رباتها قرار نیست بررسی کنند هم در ادامه این فایل آمده است. شما میتوانید صفحات مختلفی را به این لیست اضافه یا از آن حذف کنید. در خط آخر هم آدرس سایت مپ وبسایت شما درج شده است.

مرحله سوم: دانلود فایل robots.txt

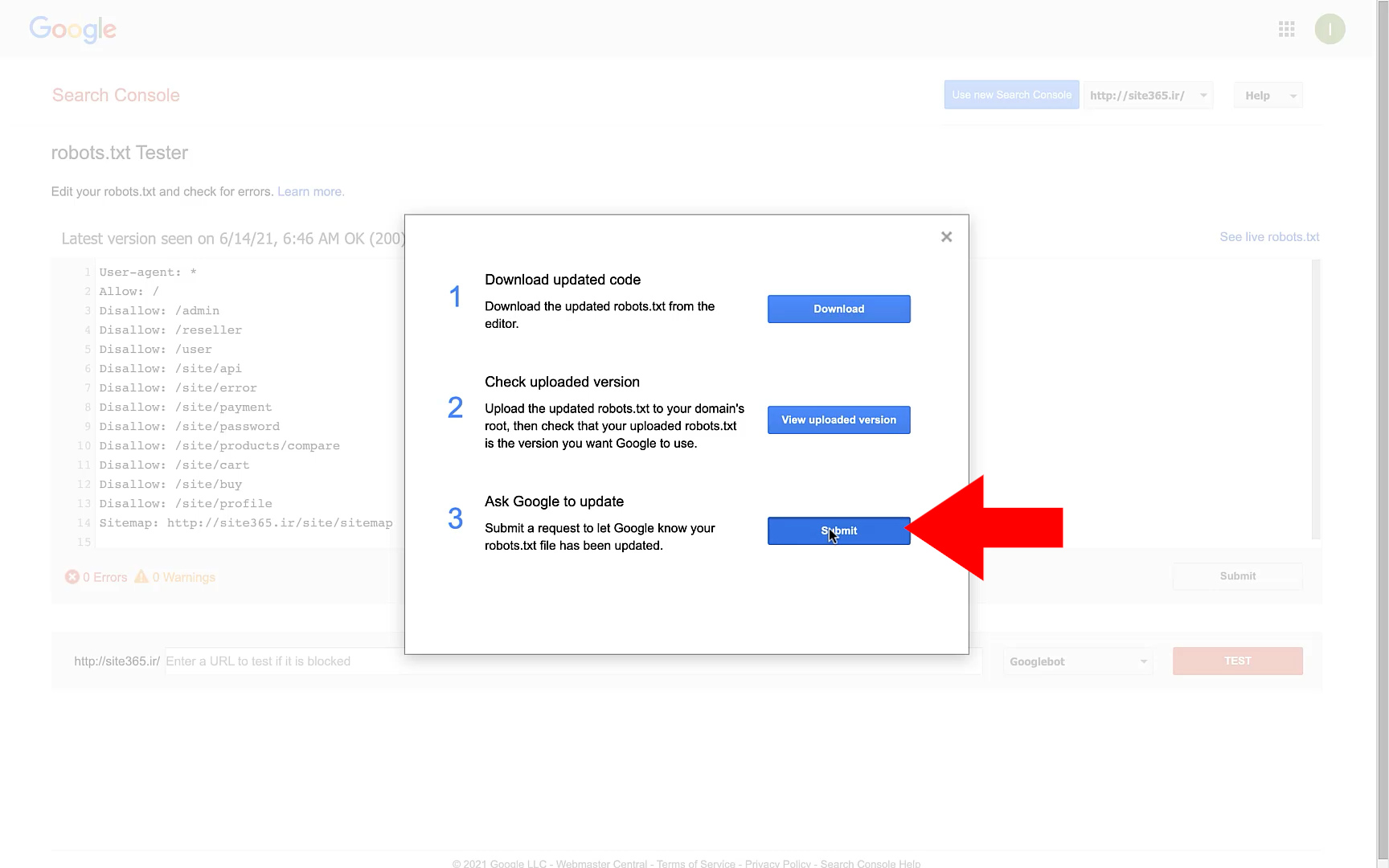

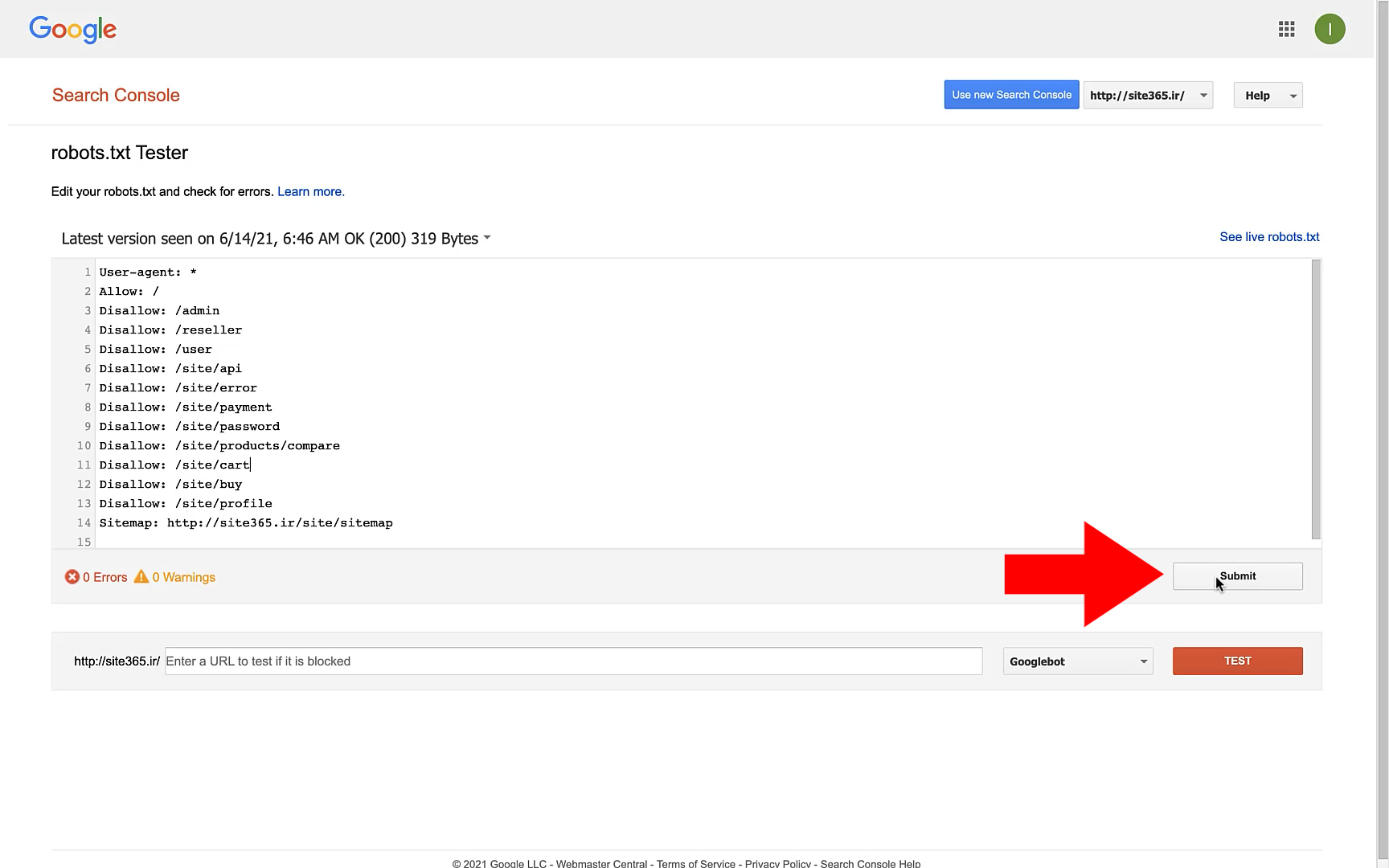

بعد از این که تغییرات موردنظرتان را در فایل robots.txt اعمال کردید، باید این تغییرات را ذخیره کنید. در پایین سمت راست صفحه روی دکمه Submit کلیک کنید.

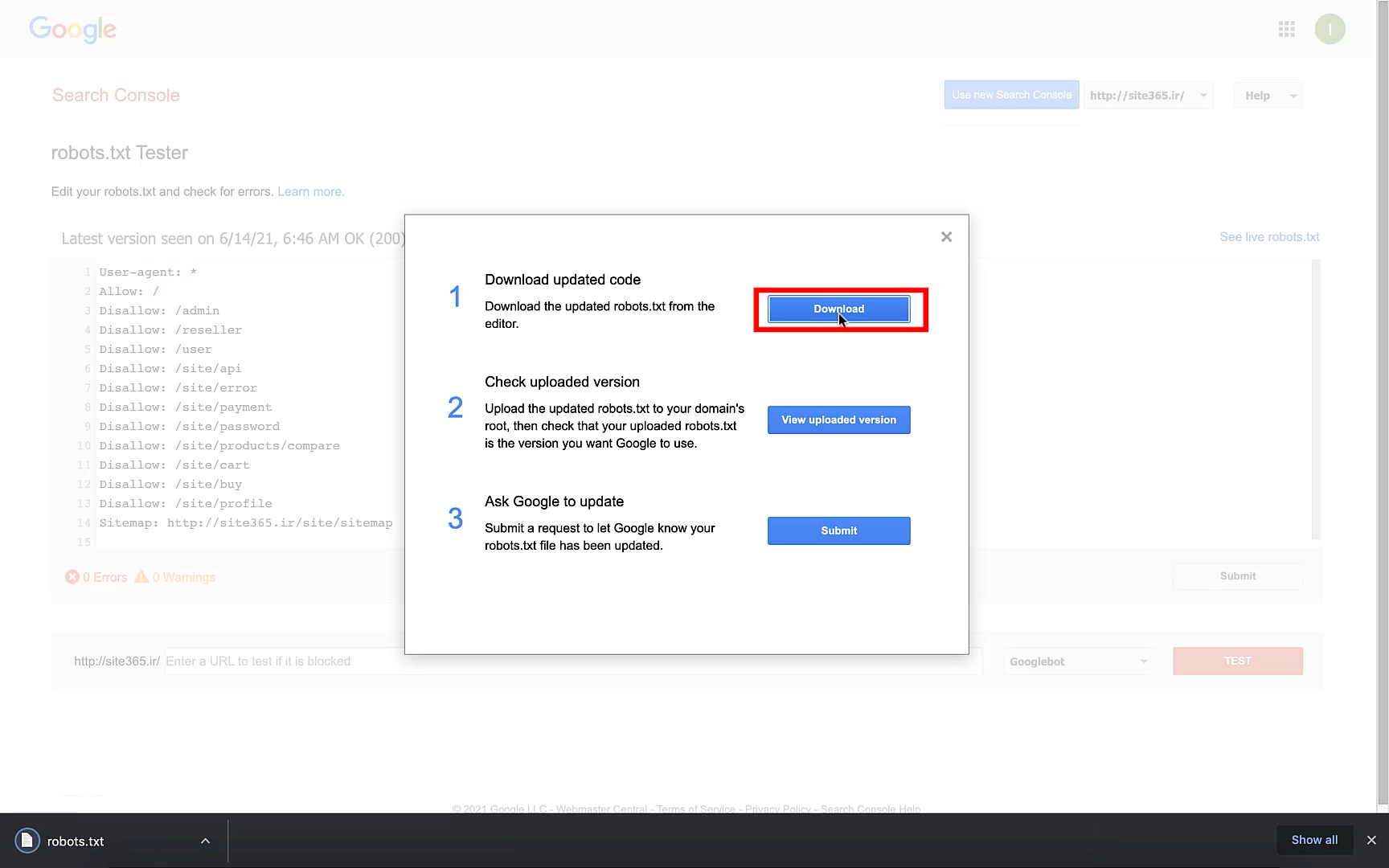

بعد از کلیک روی این دکمه، پنجرهای برای شما باز میشود. در این پنجره سه مرحله وجود دارد که باید آنها را انجام دهید. قدم اول این است که فایل robots.txt را دانلود کنید. برای این کار کافیست روی دکمه آبی رنگ Download کلیک کنید. بلافاصله فایلی با اسم robots.txt در سیستم شما دانلود میشود.

مرحله چهارم: وارد کردن فایل robots.txt در سایت

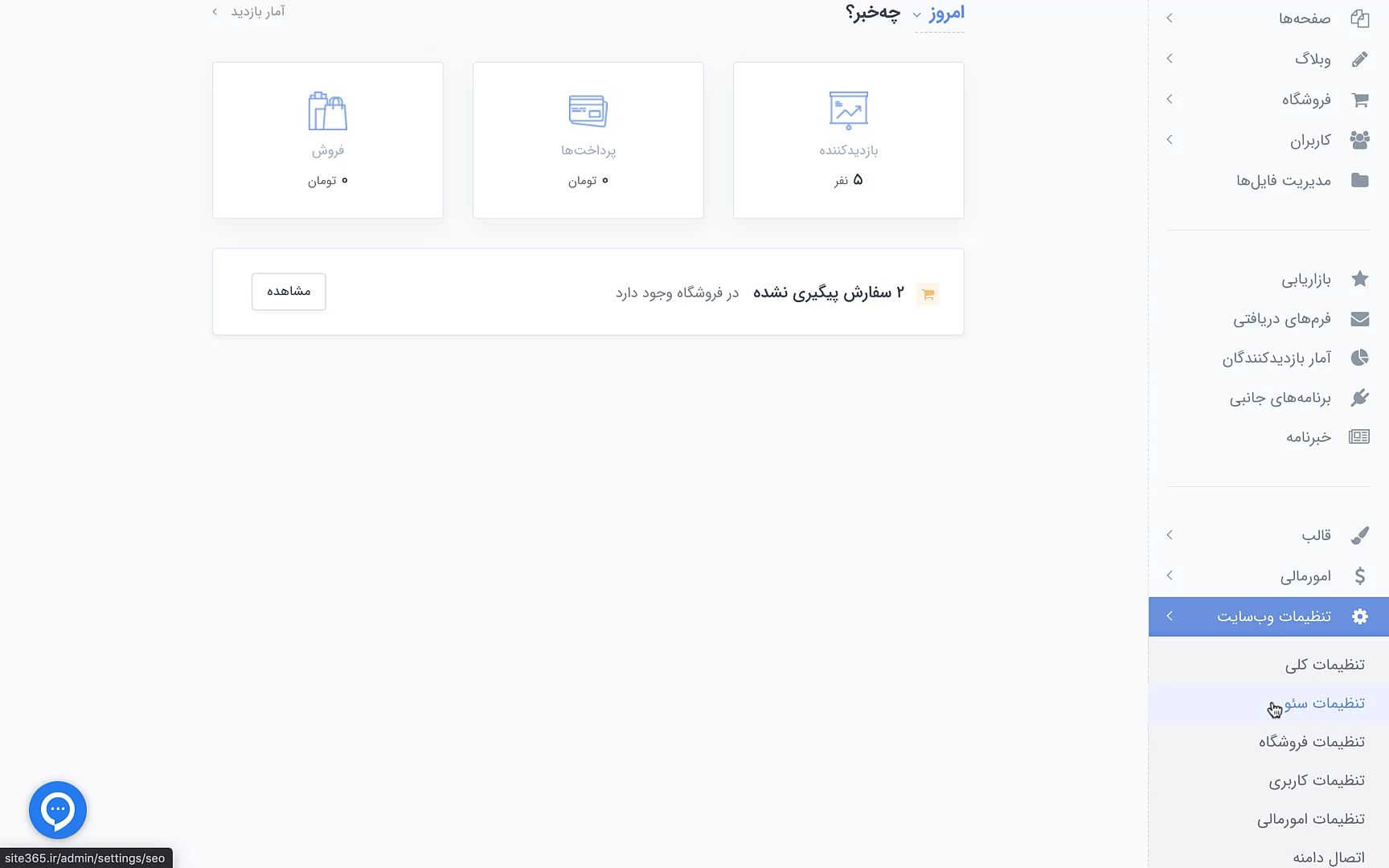

بعد از این که فایل robots.txt دانلود شد، آن را باز کنید. در ادامه وارد پنل مدیریت سایتتان شوید. از منوی سمت راست پنل روی گزینه «تنظیمات وبسایت» کلیک کنید. با این کار چند گزینه دیگر برای شما ظاهر میشود. از بین این گزینهها روی گزینه «تنظیمات سئو» کلیک کرده تا وارد بخش مربوطه شوید.

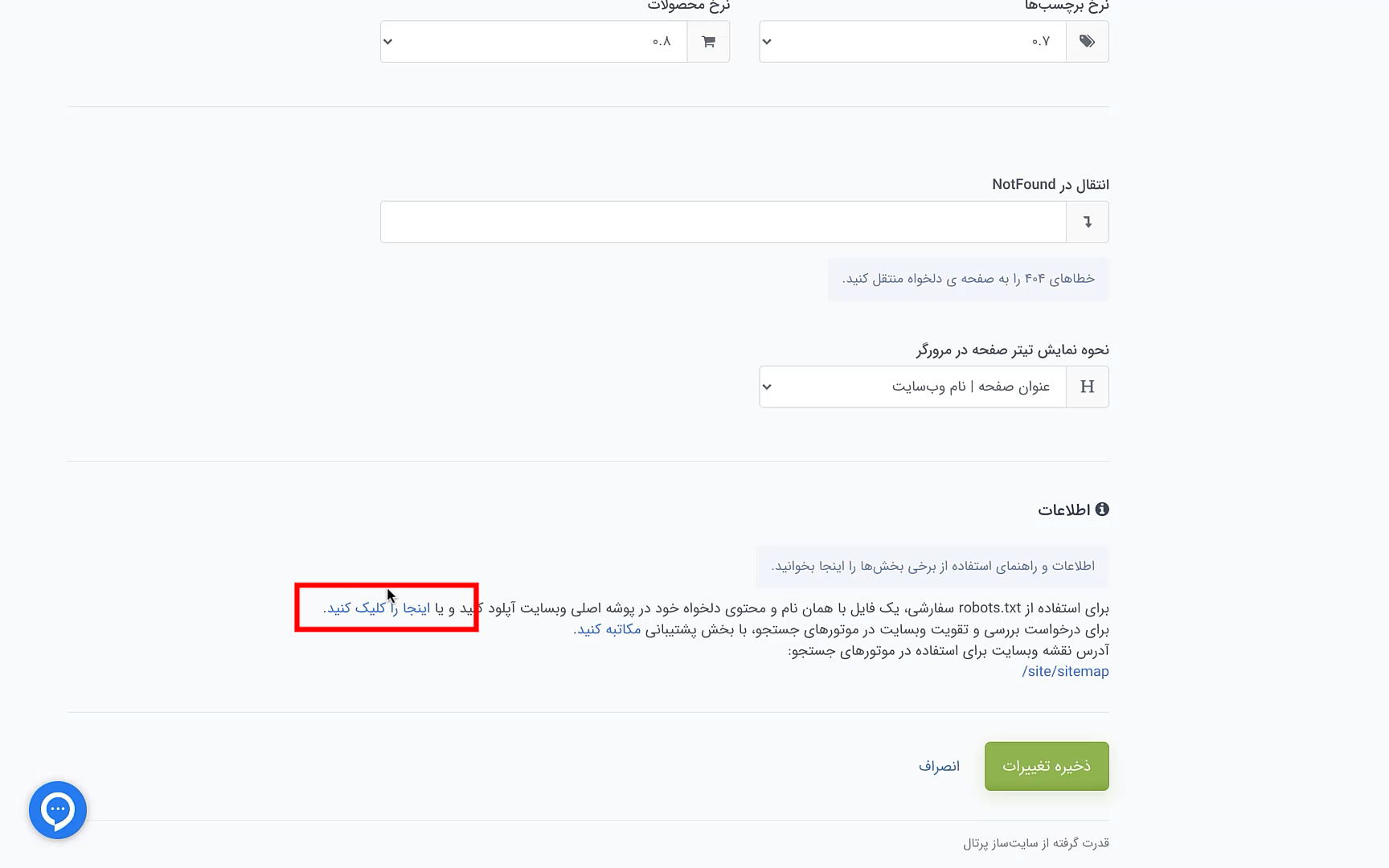

در ادامه، صفحه تنظیمات سئو برای شما باز میشود. به سمت پایین صفحه اسکرول کنید تا به قسمت «اطلاعات» برسید. در انتهای خط اول این بخش مثل عکس زیر روی عبارت «اینجا را کلیک کنید» کلیک کرده تا صفحه جدیدی برای شما باز شود.

در ادامه صفحهای مثل عکس زیر برای شما باز میشود. ابتدا تمام محتویات داخل کادر را پاک کنید. بعد تمام محتوایات فایلی که از سرچ کنسول دانلود کردید را کپی کرده و داخل کادر این صفحه وارد کنید. در نهایت روی دکمه ذخیره فایل کلیک کنید تا فایل robots.txt سایت شما ایجاد شود.

مرحله پنجم: ثبت در گوگل سرچ کنسول

بعد از این که محتوای فایل robots.txt را در سایتتان وارد کردید، دوباره به صفحه سرچ کنسول برگردید. در این مرحله فقط کافیست که روی دکمه Submit کلیک کنید. بعد از این کار فایل robots.txt شما به درستی ایجاد شده و در سایت شما قرار دارد. حالا رباتهای مختلف براساس این فایل، سایت شما را بررسی میکنند. یعنی صفحاتی که در این فایل Disallow شدهاند، توسط رباتها بررسی نخواهند شد.